一、背景

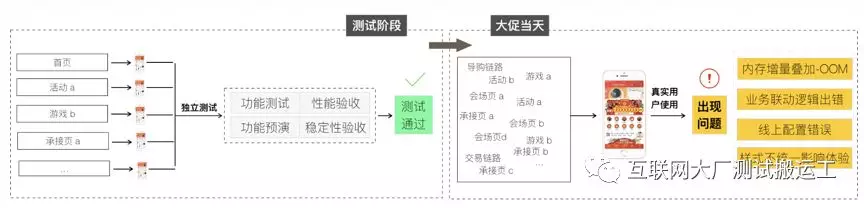

- 2017.11.01预热期开始,各个端闪退率均有不同程度的上涨

- 紧急成立专项解决,数据逐渐回落

- 主要原因为大量富媒体上线导致内存水位超高,客户端被系统杀死

- 已知的各个业务上线前均有做过性能验收

大促前验收场景均为单点,而真实用户使用路径则较为复杂,即没能构建出真实的引起性能问题的场景

下一秒会发生什么?氛围能否会正常切换,隐藏的价格是否会出现,定时出现的模块能否透出?

下一秒客户端的稳定性如何呢?在各种大图片,会场,动画,动效,游戏中徜徉的用户,内存还好吗?手机滚烫吗?会崩溃吗?

带着这些疑虑在0点后的真实场景进行验证的我们,需要在真实情况到来之前拿到一个更加确定的答案。

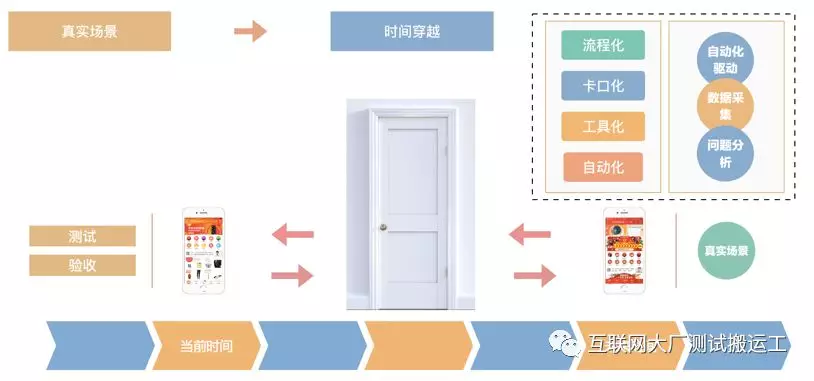

那如果想在真实的环境提前看到未来的场景,该如何做?

二、时间穿越

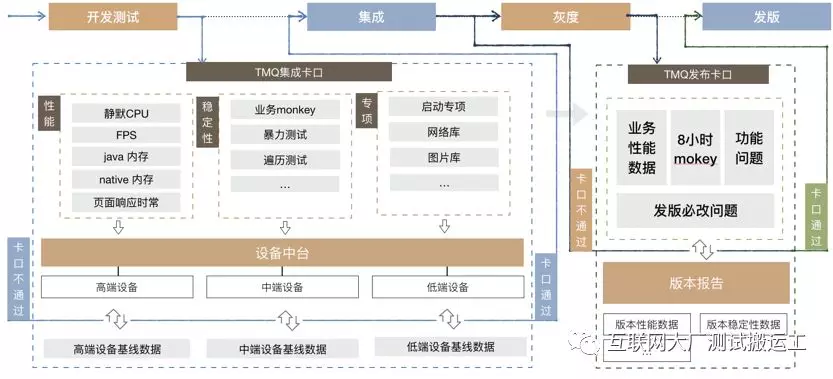

我们构造出一个未来的真实的环境,接下来在测试以及验收的过程中,通过进入这个环境,可以做到在真实的未来场景中进行测试和验收,并且通过流程化、卡口化的方式保证无遗漏,辅助自动化驱动,驱动过程数据采集以及问题分析,给出在真实场景下的结果

时空穿越的整体架构,链路长,涉及环节多,但是使用起来非常简单,只需要手淘客户端扫码添加白名单,之后将环境时间更改到目标时间,稍作等待,即可生效

在18年双十一的真实使用过程中,我们从造势、预热、正式三个关键的时间节点入手,利用时空穿越进行了针对客户端页面维度以及链路维度的验收:

在平稳度过大促之后,我们开始考虑如何将这个验收能力应用在日常的客户端质量保障中,于是开始了客户端验收常态化的项目

三、客户端验收

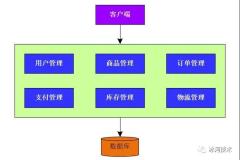

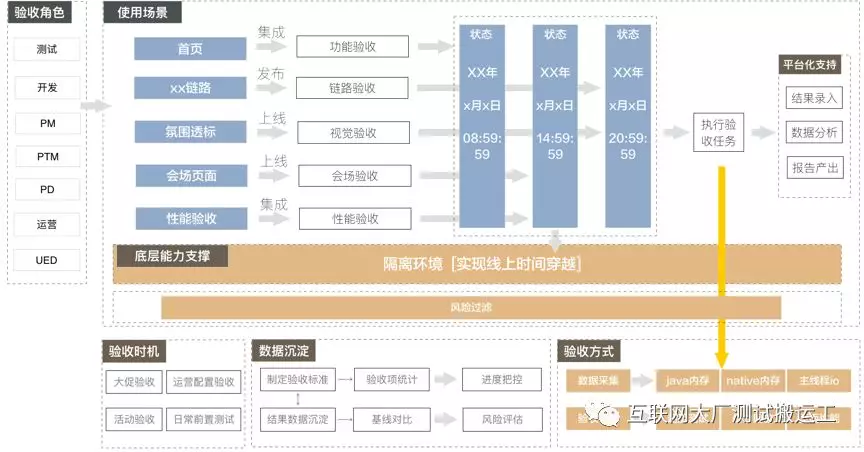

这是手淘客户端验收的流程图

四、结果

整个客户验收给18年双十一带来了比较好的成果,验收过程中发现150多个问题,验收内容基本涵盖了所有的大促活动,双十一四个端主版本均达到稳定性目标。从整体上看,今年的客户端稳定性相比去年有飞跃式提升。被誉为历年客户端最佳双十一

文章来源:AlibabaTechQA

开发者社区整理